GPT模型是什么

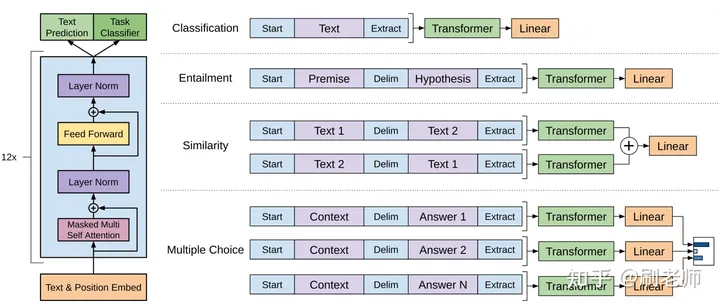

GPT(Generative Pre-trained Transformer)是一种基于Transformer架构的自然语言处理模型。

由OpenAI推出,属于预训练模型,采用了无监督的学习方式,能够对大规模文本进行学习和抽象概括,并通过微调的方式用于特定的自然语言处理任务,例如文本生成、语言翻译和问答系统。GPT模型的主要特点是它可以根据输入的上下文来生成下一个词,因此可以用于文本生成等自然语言处理任务。该模型使用了多头注意力机制、残差连接和Layer Normalization等技术,并通过多次迭代优化模型参数来提高模型的性能。

Transformer架构

Transformer架构是一种用于自然语言处理和其他序列到序列学习任务的深度学习模型,它由Attention机制和残差连接组成。Transformer的主要优点是其并行性,可以快速处理长序列数据,同时也可以避免逐步预测(autoregressive)模型中的信息丢失问题。Transformer的架构由编码器和解码器组成,其中编码器将输入序列编码成抽象的特征表示,解码器将这些特征表示用于生成目标序列。

Transformer的编码器和解码器均由若干个相同的层组成。每层都由两个子层组成:一个是多头自注意力(multi-head self-attention)层,另一个是前馈神经网络层(feed-forward neural network)。自注意力层允许模型在不同位置的输入之间进行交互和关注,前馈神经网络层则对自注意力层输出进行非线性变换。在每个子层之间,还添加了残差连接和层归一化(layer normalization)。

在自注意力层中,输入序列被分为多个头,每个头都学习一种不同的表示方式。然后,每个头都应用了一个类似于注意力机制的加权函数,以确定每个位置对其他位置的重要性。这种方式可以让模型对长序列进行高效的处理。

在前馈神经网络层中,模型将自注意力层的输出输入到一个全连接神经网络中,以学习特征表示之间的非线性关系。最终输出由多个层级组合而成,通过解码器生成目标序列或作为分类或回归任务的输出。

Transformer架构是自然语言处理和机器翻译等序列到序列学习任务中的重要模型,并在各种项目中都有应用。

多头注意力机制

多头注意力机制是一种用于增强神经网络模型的机制,可以在同一时间对不同位置的信息进行多次并行处理。它可以被应用于很多场景,例如自然语言处理、图像处理等。在多头注意力机制中,模型将输入进行线性变换,并将变换后的结果分成多个头(head)。然后,每个头都会独立地执行注意力操作,并将结果合并为一个输出向量。这个机制使得模型能够同时关注到输入中的不同方面,提高了模型的表现力和泛化能力。

残差连接

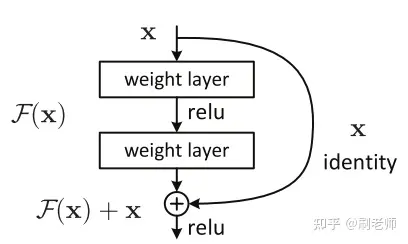

残差连接(Residual connections)是一种神经网络中常用的技术,旨在解决神经网络训练过程中的梯度消失和梯度爆炸问题。它通过在网络中添加跨层连接,使得网络能够更好地传递梯度信息,从而提高网络的训练效果。

在残差连接中,神经网络的输入被直接添加到输出中,形成了一个“shortcut”。这样,在反向传播时,梯度可以通过这条“shortcut”直接流向前面的层,避免了在反向传播过程中梯度消失或梯度爆炸的问题。

残差连接最早应用于残差神经网络(ResNet)中,但现在已经广泛应用于其他类型的神经网络,如卷积神经网络(CNN)和自注意力机制(Attention)。

Layer Normalization

Layer Normalization是一种用于神经网络的正则化技术,其主要目的是减少内部协变量偏移的影响。在神经网络中,协变量偏移是指网络每一层输入的分布随着网络参数的更新而发生变化的问题。这会导致网络训练变得更加困难,因为每层的输入都会被预处理成具有相同的分布。

Layer Normalization通过在网络的每一层的输出上应用归一化操作来解决这个问题。这个归一化操作将每个输出向量的元素都缩放到均值为0和方差为1的标准正态分布中。这使得网络的每一层的输入分布保持不变,并且有助于提高网络的泛化能力和训练速度。

在具体实现上,Layer Normalization是一种基于统计分布的方法,它通过计算每个样本中所有元素的均值和方差来计算每个层的参数。这些参数被用来缩放和平移归一化后的输出向量。由于Layer Normalization是对每个样本进行归一化的,因此它对于小批量训练和在线学习非常有效。